Seguendo l’evento online - che potete trovare a questo link - è facile percepire la portata di ciò che sta per accadere: Google ha ufficialmente inaugurato una nuova era dominata dall’intelligenza artificiale.

Il Google I/O 2025 si è confermato ancora una volta come uno degli eventi più attesi nel mondo della tecnologia. L'evento ha tracciato in modo netto la direzione futura di Google: un ecosistema interamente guidato dall'AI, capace di ridefinire l'interazione degli utenti con le informazioni, la comunicazione e la produttività quotidiana.

L'azienda di Mountain View ha presentato innovazioni rivoluzionarie: dall'AI generativa alle esperienze immersive, fino a nuove integrazioni hardware-software nel mondo della realtà estesa (XR). Tutti i principali prodotti – Search, Workspace, Android e persino YouTube – stanno vivendo una trasformazione radicale guidata da Gemini 2.5 e DeepMind, con l'obiettivo di rendere ogni interazione più naturale, contestuale e predittiva.

Vediamo insieme i principali cambiamenti già rilasciati negli Stati Uniti e destinati ad arrivare presto anche in Italia e nel resto del mondo.

Google Search si evolve: AI Overviews e AI Mode per una ricerca più interattiva

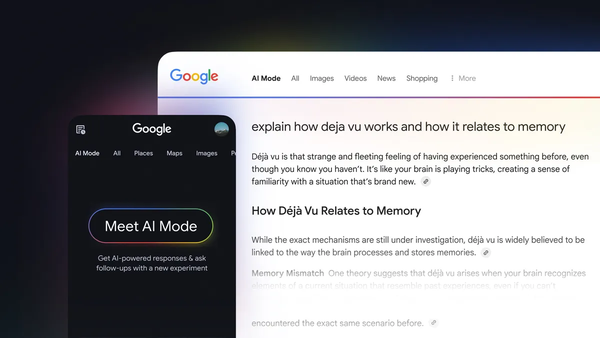

Al Google I/O 2025, una delle novità più trasformative è stata la presentazione di AI Mode, una nuova modalità di interazione che porta Google Search oltre i limiti della tradizionale ricerca a link. AI Mode è in una scheda separata ed è progettato per gestire query più complesse rispetto a quelle che le persone hanno storicamente utilizzato per Search. Insieme alle già annunciate AI Overviews, AI Mode rappresenta un cambiamento strutturale nell'esperienza utente: la ricerca diventa più conversazionale, visuale e personalizzabile.

AI Mode è una nuova interfaccia basata sull'intelligenza artificiale generativa di Gemini, progettata per chi desidera "parlare con Google" in modo più naturale e approfondito. Potresti usarla per confrontare diversi fitness tracker o trovare i biglietti più economici per un evento imminente. Quando attivata, consente di esplorare un argomento attraverso un dialogo continuo, porre domande di follow-up, ottenere spiegazioni più dettagliate, confrontare opzioni o chiedere chiarimenti su ciò che è stato appena mostrato.

Approfonidsci l'articolo Generative Engine Optimization? Ecco perché nel 2025 dovresti pensare AI-first

Le AI Overviews, già disponibili per tutti gli utenti negli Stati Uniti, sintetizzano i contenuti più rilevanti provenienti da fonti attendibili, mostrando risposte complete e ricche di elementi multimediali (immagini, mappe, video, caroselli interattivi) direttamente nella SERP.

Principali novità introdotte:

-

AI Mode: una nuova esperienza interattiva di ricerca, attivabile direttamente da Search

-

Conversazioni dinamiche con Gemini per approfondire un argomento o cambiare direzione

-

AI Overviews integrate sopra i risultati classici, con sintesi generate in tempo reale

-

Ricerca multimodale che combina testo, immagini e input vocali

-

Risposte contestualizzate, adattate alle preferenze e al comportamento dell'utente

-

Integrazione con Lens e miglioramenti significativi nella ricerca visiva

-

Grafici personalizzati: AI Mode sarà presto in grado di creare grafici personalizzati

È stata introdotta una nuova esperienza di shopping AI Mode che unisce capacità AI avanzate con il Shopping Graph di Google per aiutarti a navigare per ispirazione, considerare varie opzioni e trovare il prodotto giusto per te.

Google ha anche sottolineato l'importanza di valorizzare i contenuti originali: gli editori e i creator continueranno a ricevere visibilità attraverso i link presenti nelle overview e avranno accesso a nuovi strumenti di tracciamento del traffico generato dall'AI.

Gemini 2.5: il motore AI di nuova generazione

Gemini 2.5 è ora disponibile in oltre 35 lingue in più di 200 Paesi. Con una finestra di contesto fino a 2 milioni di token - unità di base in cui i modelli di linguaggio processano e comprendono il testo - Gemini può analizzare documenti lunghissimi, video, file, codice e dataset in modo fluido.

È integrato in:

-

Gmail, Docs, Drive, Meet e Calendar;

-

Android, come assistente nativo su Pixel e dispositivi compatibili;

-

Gemini Advanced, disponibile per chi sottoscrive Google One AI Premium.

Nuove funzionalità principali:

-

Supporto a file multiformato (PDF, fogli, slide).

-

Pianificazione automatica, sintesi, scrittura e risposte intelligenti;

-

Modalità offline e sincronizzazione cross-device;

-

Gemini Live con nuove capacità camera e screen sharing: Gemini Live ottiene camera e screen sharing gratuitamente su Android e iOS a partire da ora;

-

Integrazione con app Google: nelle prossime settimane, Gemini Live sarà in grado di collegarsi alle tue app Google preferite come Keep e Calendar;

-

Deep Research: a partire da oggi, puoi contribuire con i tuoi file per aiutare Deep Research.

Traduzioni AI in tempo reale e riepiloghi automatici in Google Meet

Durante il keynote, Google ha annunciato nuove funzionalità basate su Gemini per Google Meet, pensate per migliorare la comunicazione globale e l'efficienza nei meeting virtuali:

-

Traduzione automatica in tempo reale delle conversazioni in Meet (live caption multilingua);

-

Riepiloghi automatici dei meeting con azioni, decisioni e punti salienti;

-

Scheduling intelligente integrato con Calendar.

Project Astra: l'evoluzione avanzata di Gemini Live

Project Astra rappresenta la versione sperimentale e potenziata dell'assistente AI di Google, costruita sulla base del modello linguistico Gemini. Mentre Gemini Live offre già conversazioni vocali fluide, Project Astra porta l'esperienza a un livello superiore aggiungendo capacità visive e di memoria avanzate.

La differenza chiave:

-

Gemini Live è l'assistente vocale attualmente disponibile che permette conversazioni in tempo reale;

-

Project Astra è la versione sperimentale che integra le capacità di Gemini Live con funzionalità visive e di memoria.

Funzionalità avanzate di Project Astra:

-

Visione in tempo reale: analizza quello che vede attraverso la fotocamera del dispositivo;

-

Memoria conversazionale: ricorda le discussioni precedenti tra sessioni diverse;

-

Riconoscimento visivo: identifica oggetti, testi e situazioni nell'ambiente;

-

Conversazione multimodale: combina voce, testo e immagini in una sola esperienza.

Le funzionalità più avanzate di Project Astra sono ancora in fase di test con utenti selezionati. Google sta gradualmente integrando queste capacità sperimentali nell'esperienza Gemini Live standard, rendendo l'assistente sempre più simile alla visione originale di Project Astra.

Integrazione futura: Project Astra è progettato per funzionare su diversi dispositivi, dagli smartphone agli smart glasses, preparando il terreno per Android XR e un ecosistema di assistenti AI universali.

Creatività AI: Imagen 4, Veo e nuovi strumenti

Uno dei settori più interessanti delle novità presentate al Google I/O 2025 riguarda la creatività generativa, dove Google ha dimostrato come l'intelligenza artificiale possa diventare un potente alleato per creator, artisti e professionisti del settore multimediale. L'azienda ha ampliato significativamente la propria offerta di strumenti creativi, consolidando la propria posizione nel campo della generazione di contenuti attraverso l'AI.

Al centro di questa rivoluzione creativa troviamo Imagen 3, 4 e 4 Ultra la nuova generazione del modello per la creazione di immagini iperrealistiche che promette qualità fotografica e controllo creativo senza precedenti. Parallelamente, Veo si conferma come lo strumento di punta per la generazione di video in alta definizione direttamente da prompt testuali, aprendo nuove possibilità per la produzione di contenuti video professionali.

Ma le novità non si fermano qui. Google ha presentato Whisk Animate, un'innovativa funzionalità che sfrutta la potenza di Veo 2 per dare vita alle immagini statiche, trasformandole in animazioni fluide e coinvolgenti. Questa tecnologia rappresenta un ponte naturale tra fotografia e video, permettendo ai creator di esplorare nuove forme espressive.

Un'altra innovazione degna di nota è Daily Listen, che utilizza le capacità AI avanzate di Google per creare contenuti audio completamente personalizzati, adattandosi ai gusti e alle preferenze individuali degli utenti. Questo strumento apre scenari interessanti per podcast, audiolibri e contenuti educativi su misura.

Completano il quadro MusicFX e TextFX, strumenti specializzati che permettono di creare musica, effetti sonori ed esperienze testuali immersive, democratizzando l'accesso a strumenti di produzione musicale e narrativa che prima richiedevano competenze tecniche avanzate.

Sviluppatori: Gemini 2.5 Flash e nuovi strumenti

Google ha dedicato particolare attenzione alla community degli sviluppatori, presentando Gemini 2.5 Flash come risposta alle esigenze di performance e scalabilità del mondo development. Questo modello leggero rappresenta un'evoluzione significativa rispetto alle versioni precedenti, essendo specificamente ottimizzato per casi d'uso ad alta frequenza e bassa latenza, caratteristiche fondamentali per applicazioni real-time e servizi che richiedono risposte immediate.

L'ecosistema di sviluppo si arricchisce di strumenti più potenti e accessibili. Gli SDK aggiornati per Android, iOS e Web offrono ora un'integrazione nativa più profonda con le capacità AI di Google, semplificando notevolmente il processo di implementazione per gli sviluppatori. Particolare rilievo assume l'integrazione con Firebase, che permette di creare app AI-native con un'architettura cloud-first, riducendo la complessità dello sviluppo e accelerando i tempi di deployment.

Sul fronte del debugging e dell'ottimizzazione, Google ha introdotto nuove funzionalità per Chrome DevTools che permettono agli sviluppatori di monitorare e ottimizzare le performance delle applicazioni AI in tempo reale. Inoltre, la nuova Console Gemini API su Google AI Studio offre un ambiente di sviluppo unificato dove testare, iterare e distribuire soluzioni basate sull'intelligenza artificiale con maggiore facilità e controllo.

Android XR: la rivoluzione della realtà estesa

Con l'annuncio della piattaforma Android XR, Google entra ufficialmente nel mondo della realtà estesa. Xreal, leader globale nel settore degli occhiali AR consumer, ha annunciato che Project Aura sarà tra i primi smart glasses Android XR sul mercato, con rilascio previsto per il 2026. I glasses Xreal Project Aura rappresenteranno il secondo device ufficiale Android XR dopo il visore Samsung Moohan.

Caratteristiche principali:

-

Supporto per hand tracking, spatial computing, eye tracking

-

Integrazione con servizi Google e app Android

-

Marketplace dedicato per contenuti XR

-

Strumenti avanzati per sviluppatori

-

Collaborazione con Samsung e Qualcomm

L'AI Agentiva al centro dell'ecosistema Google

Il Google I/O 2025 ha segnato il passaggio definitivo verso un ecosistema in cui l'intelligenza artificiale non è solo uno strumento, ma diventa "agente" - capace cioè di agire autonomamente per conto dell'utente. Google sta facendo ricerca all'avanguardia per costruire l'AI più utile che sia più intelligente, agentiva e personalizzata.

Con Gemini 2.5, Search rinnovato, Android XR e gli strumenti per creator, Google punta a rendere l'AI uno strumento utile, inclusivo e potente per tutti, mantenendo un forte impegno verso la responsabilità, la trasparenza e la sicurezza.